一种全景监控系统网络分类学习在ADAS系统中的应用

先进的驾驶员辅助系统ADAS需要依赖众多的传感器(比如毫米波雷达,激光雷达,超声波雷达和前视摄像头,环视摄像头等)用于场景理解和预测,这些传感器通常用于检测交通参与者和导航所需的场景元素。而其中的大部分场景认知是基于前视摄像头系统,其中包括相关车道线探测,车辆、行人等目标类型,限速标识牌,红绿灯标志,环境光标识等信息,在该领域的最新进展的推动下的计算机视觉分析算法在ADAS系统目标检测中可以达到激光扫描低成本的性能。但是对于是仅仅利用前视摄像头进行探测的方案实际是存在一些缺陷的。比如如下场景可能出现误识别现象:

1)当较近距离的跟车行驶,很多时候会遮挡车道线的识别;

2)当跟车停止过程中,前方较近距离有行人或骑行者突然切入时,可能会出现漏识别;

3)仅仅物体检测系统通常不足以实现自主的紧急制动和前撞系统,因为各种可能的道路障碍物(例如树木、树枝、小动物)和道路结构(例如国家/地区道路),不同的纹理使得仅依靠训练集合无法完全覆盖实际典型的道路场景。

概 述

当然当前已有一些环境识别增强方案,如增加多摄像头方案,需要在车辆四周各布置一些冗余摄像头(也即nCameras),又或者在前后左右均增加一些角雷达(nRadars)用于探测周边障碍物。但是这些方案的成本都颇高,且效果也不一定理想。由于目前很多车型均已将全景环视监控系统(AVM)纳入标准配置中,而其在ADAS前向开发中也具有巨大的实现潜力,诸如在停车和驾驶模式下可以很好的辅助行车辅助系统前雷达探测,从而实现目标的成本大幅降低。

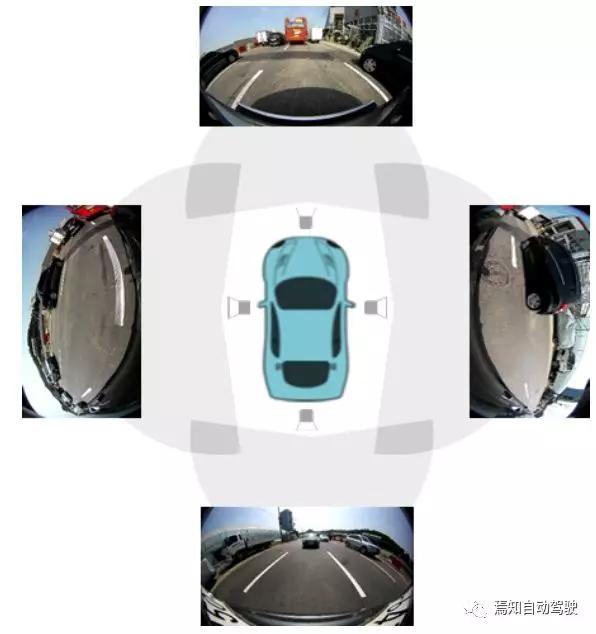

如下图表示了一种典型利用鱼眼图像进行环视监控的全景监控系统。鱼眼图像是一个广角畸变的图像,通常用于“环视监控”(AVM)系统。在鱼眼镜头上使用鱼眼镜头在自动驾驶领域具有明显的优势,因为它们提供了比传统相机的视角要宽得多(190°),从而捕获有关汽车周围环境(行人,障碍物等)的更多相关信息。四个相机分别位于前,后,左侧和右侧车辆,并为驾驶员提供360度全方位视野以便检查车辆周围是否有障碍物。

本文举例说明一种基于全景监控系统实现端到端应用增强型ADAS辅助系统,以高度准确的方式描述了网络家族解决方案和低复杂度解决方案,通过3D对象检测进一步扩展基础架构。其基本策略如下:

划定最接近障碍物的新解决方案

其全景摄像头通过识别行驶中每个方向上的最近障碍物,确保每一帧图像的安全可驾驶区域车辆,我们使用这种方法来计算到最近的障碍物,我们将其整合到联合对象检测中,以优化对于安全驾驶区域的检测。驾驶车辆的所有方向都通过底部点估计和边缘检测,同时还确定最近障碍物每个方向的确切距离。

通过障碍物底部的自由行驶区域点估计,将障碍物检测网络集成到能够共同划界的统一端到端解决方案中,其中边缘检测和2D多尺度目标检测,可降低复杂度。

扩展2D对象检测以找到确切的3D物体姿势

由于2D对象检测有时无法提供足够的信息以进行场景理解,因此我们需要使用3D信息来扩展当前的解决方案,以找到物体在3D世界中确切的姿势或坐标。在方案设计中,可以通过设置一种高精度解决方案增加检测每个物体的方向和尺寸。同时,该方案也侧重于检测基础安全驾驶的场景信息:物体检测,路缘检测,自由驾驶区域分割或自由空间检测,物距从相机和对象的方向等。

卷积神经网络结构细分

“自由空间检测”包含对象检测、对象分类、自由空间分割以及3D方向检测等。在如何制定有效的道路分割策略上可以有如下几种较为典型的卷积神经网络方案可供选择。使用“全卷积网络(FCN)”的卷积层在空间上执行密集的预测任务,例如使用转置的卷积模型进行上采样。此外,还可以引入了“膨胀卷积”来增强网络的接受领域。

传统的神经网络方法研究通常以像素为单位处理像素分割网络,而深度图则使用立体相机进行多维拍摄图像来预测目标对象的世界坐标。对于提到的这些方法,需要对未分类的像素进行复杂的后处理才能处理他们。在本文中,我们建议使用更简单的架构,通过识别各个障碍物在各个方向上的底点来检测障碍物,并通过划分“自由空间”检测驾驶车辆。

现代神经网络方法对物体检测可以分为两类:基于区域建议的方法和单发方法。前一类方法首先需要生成使用区域建议网络RPN,然后使用辅助模块对其评分及分类整合。而在后一种单发网络方法中,区域建议和分类阶段被整合到一个单一的阶段,使用预定义的锚定框(该瞄定框表示在特征上每个空间位置移动的滑动窗口均进行映射),以同时预测目标边界框并对其相关置信度得分进行统计。两种方法相比,执行区域建议和分类网络的同时进行,使得卷积网络的执行效率大幅提升。

在自动驾驶中,3D对象检测重点在应用程序中考虑在原始需求与真实场景中的对象进行交互设计。这个问题需要从纯粹的几何观点出发(例如通过单个6维自由度6DoF来估计对象的姿态图片),进而使用深度卷积神经网络DCNN以重建3D模型。对于2D图像使用局部仿射不变性来描述符合构造对象实例的3D模型,然后将它们与先验数据集中的3D姿势进行匹配,以估计对象在0°到360°的方向。

基于如上分析,可以充分将“场景理解网络”用于AVM场景理解的体系结构中,该体系结构包括对象检测,自由/可驱动区域分割,对象距离和对象方向。对于2D对象检测我们研究标准物体检测网络如Faster R-CNN和SSD 。AVM数据集上可以使用不同的编码器,然后将它们插入到标准对象检测网络中,以评估准确性和运行时性能。所有底点的并集图像代表所有障碍物的底部边界场景,而其下面的所有像素均被视为自由空间,所以,通过将相机姿态应用于底点,可以算出与障碍物的最近距离的一个对象,可以通过找到图像中每个像素列的底点来实现初级的可用空间检测。另外,针对多任务网络架构则建议执行联合3D物体目标检测和底部低复杂度解决方案的点定位。

1、底网

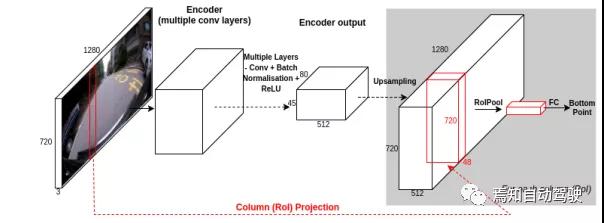

自动驾驶系统开发中较难的场景包含如车道路缘、护栏、各类不同的交通标志等。基于网络的解决方案可以大大简化这一检测过程。最初,网络将图像的每个垂直列作为输入。如下图所示网络使用的输入列宽度为24,重叠在23个像素上。然后将每列通过卷积网络以输出k个标签,其中k为高度尺寸。由此,可利用该列对障碍物底部像素对应的位置进行分类,最终所有列的并集将建立道路实时路缘或自由驾驶区域。

在基于列的计算架构中,存在大量的计算冗余。为了解决该冗余问题,我们将利用端到端架构的网络实施优化单纯列式。该网络使用多个将图像编码为深度特征图卷积层,然后使用多个上采样层来生成具有与输入图像相当的匹配特征图。与检测系统感兴趣区域(ROI)方法相类似,裁剪检测窗口时,需要裁剪与像素列相对应的图像的硬编码区域加上23像素的相邻区域作为一个结果,生成的特征窗口为宽23像素,高720(高)像素。

我们将此窗口水平滑动到每个x坐标。然后将生成的图像调整为固定大小ROI合并层中的长度(例如7x7),然后分类为k类之一(在高精度情况下,k为720,即图像的高度),以便最终预测到最低点。如下图给出了该架构的图示。

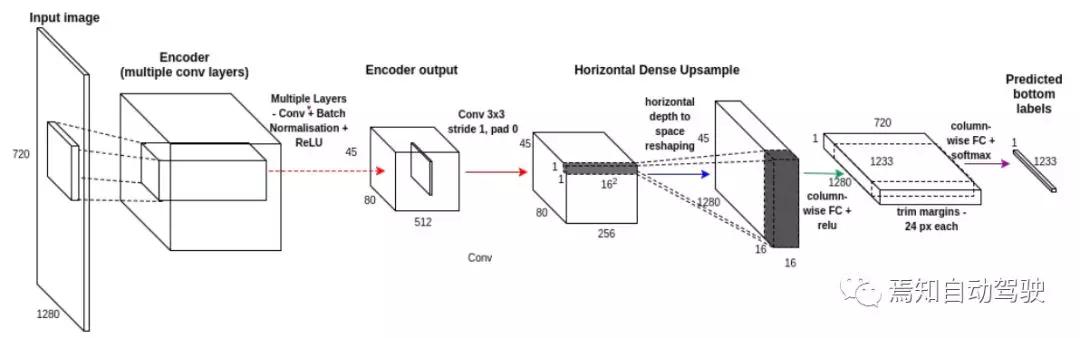

但是,将固定位置的ROI卷积计算中可能由于某些区域性重叠导致重复计算。此时针对底部预测任务的最终分类层是使用“单发方法”。为了提高网络效率,通过替换解码器部分,减少了16倍原始图像尺寸,生成的结果特征图应用跨度>1的多个卷积的分辨率,对应于具有单个密集水平上采样层的多个上采样层的网络的特征。与使用标准的底层预测网络的先前版本相比在水平和垂直方向上的向上采样层,其宽度乘以16倍,而高度保持不变。最后,在水平上采样层,以线性组合每列的输入,使用softmax分类每个列k的结果。每个列分类子任务都会自动考虑显示在被分类的中心列的接近度,代表最终的底部预测。

2、 OD网

为了预测场景中对象的边界框和类别,需要研究基于Faster R-CNN的初始架构。该架构深度结合了Inception-ResNet-V2等功能强大的编码器,并提供了最精确的模型作为高精度解决方案,但由于车载嵌入式系统本身存在的实时性差的问题,在计算效能上会存在一定缺陷。为了确保车载嵌入式系统低复杂度解决方案的响应能力,需要组建一个有效的对象检测网络系统(也即OD网),直接输出对象类别的概率和边界框坐标。这里可以结合类似像移动网中的光编码器快速检测镜头进行推理。

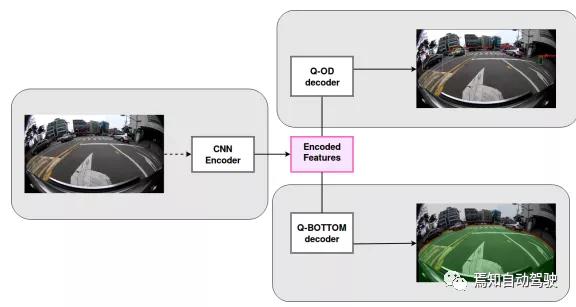

3、统一网

统一网相关体系结构结合了底部预测和对象检测网络,通常利用网络编码器的共享计算优势,以获得更好的训练优化和运行时性能。期间,我们需要考虑不同的位置分支共享编码器层,为了在运行时性能和准确性之间找到最佳平衡,我们建议使用统一架构对图像进行编码,并使用卷积网络对每个编码任务进行解码。

在输入层分支意味着两个网络不共享任何计算,在精度方面,此体系结构是一个上限。更高的网络分支使我们可以在两个任务之间共享计算并获得更好的推理时间,但准确性较低,因为两端必须共享编码器中的特征表示。卷积编码器的高级功能在以下方面与底部预测和目标检测略有不同。

4、3D网络

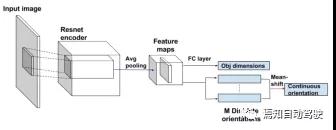

在本节中,我们介绍了高精度的解决方案方向和尺寸问题。我们使用ResNet-101中所述,底层DCNN体系结构(前22个剩余块)在具有1000个类的图像网络子集上进行了预训练。最终的架构包括两个分支,用于基于角度离散化和对象尺寸回归。

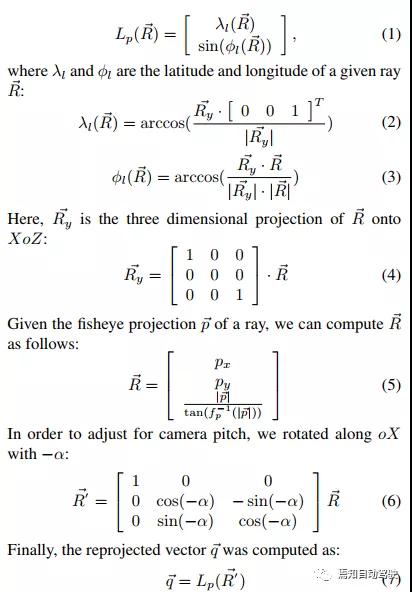

3D网络将对象作为输入并估算现实世界的尺寸和方向。使用OD网络提取2D作物,然后从鱼眼投影重新投影到Lambert圆柱等面积投影。Lambert投影函数可以描述为:

网络预测对象的尺寸和对象取向。我们将方向预测转换为通过离散化取向值来分类问题分为N个独特的方向。随后,我们恢复了使用均值漂移算法实现连续定向。

实施步骤

对于利用全景监控系统的进行3D目标检测而言,我们需要对函数进行如下三个步骤的检测已获得检测对象在世界坐标下三维立体效果。

预处理:作为数据集扩充,我们使用随机的颜色失真(亮度,饱和度,对比度,色相)

并在[0; 1],我们还使用水平翻转扩展了训练集,低复杂度解决方案还执行随机裁剪。

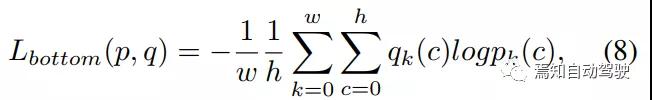

目标函数:底网使用softmax交叉熵损失对驾驶车辆各个方向上每个障碍物的每个底点进行分类:

其中w和h是每一帧的宽度和高度。

如上所述的统一网总结了三个目标功能:底部像素预测的一种分类损失和检测任务的两个损失,分类和界限框回归。

设计指标:对于目标检测任务,我们在0.5个交点处使用经典的平均平均精度(mAP)指标过度联合(IoU)重叠。对于底部像素预测任务,使用了平均绝对误差(MAE),代表地面之间的平均像素位移真实值和底部像素预测。我们将MAE指标重新用于3D网与OD网任务以计算对象方向和用于所有三个轴上的对象尺寸。

低复杂度解决方案对象检测:针对自动驾驶或ADAS系统而言,运行时性能和内存占用对于实时应用至关重要,而对于即时车辆控制的实时嵌入式系统,计算效率更为重要。我们针对此要求提出的嵌入式解决方案,该方案使用移动网络编码器解决了对象检测和底部检测两个相关任务像素检测。因此,统一网会以更高的卷积分支编码器层。关于物体检测任务可以选择使用多尺度单发网络达到快速的运行性能。对于编码器,可以使用精简版的移动网,同时在消除该移动网编码器中的最后2个卷积层可以提高精度。采用6个比例尺检测物体,使用最后一个编码器层(“ conv11”)作为第一个功能映射并创建其余5个作为编码器的扩展,每个特征图都负责检测对象在不同的规模。统一网的培训过程使用640x360像素分辨率图像,每批次训练8个。我们使用初始学习率为7e-4,并从40000次迭代的总数中每10000次迭代衰减一次。

高精度解决方案对象检测:为了获得最佳精度,可以使用Inception-ResNetV2架构的顶部作为编码器,权重在图像网,用于底部预测和对象检测。对于目标检测任务,可以选择Faster R-CNN架构,可提供最佳的本地化和分类精度。训练以全尺寸分辨率:1280x720批次大小,同时保持与原始实施相同的训练过程。

总 结

在本文中,我们介绍了一种检测通过的底点估计可行驶区域面积,以及驾驶车辆的各个方向上的障碍物,并将其整合到一个多任务统一架构中,生成低复杂度解决方案,使用已经集成搭载的全景监控系统可免费检测路沿、护栏等可分割区域。同时可对不同类型目标障碍物:汽车,公共汽车,卡车,脚踏车等进行检测和姿态分解。该3D网络的集成可以作为发展低复杂度解决方案和高精度解决方案以便提高整体性能。

龚淑娟

李峥

热点文章

-

价值重构 生态竞争

2026-02-26

-

AI驱动下的汽车产业发展趋势及应对策略

2026-02-27

-

“锂欧佩克”的崛起与我国锂资源安全战略研究:挑战、影响与应对路径

2026-02-28

-

新能源车锂电池市场分析-2026年1月

2026-02-24

-

罗兰贝格注资Jonas Andrulis新创企业,深度赋能人工智能应用领域

2026-02-24

-

一文理清全主动智能底盘,主动悬架800V和48V之争的真相

2026-02-24

-

从炫技到生产力,均胜电子打通机器人落地工业场景应用“最后一公里”

2026-02-24

-

“锂欧佩克”的崛起与我国锂资源安全战略研究:挑战、影响与应对路径

锂是新能源汽车与储能系统的关键原材料,其战略价值日益凸显。2025年7月,玻利维亚、阿根廷和智利组建了全球首个锂资源协调机制——“锂欧佩克(LithiumOPEC)”,通过股权管控、上调开采费与推进定价主导等方式,试图重塑全球锂资源供应链的利益分配格局。本文分析其形成背景、运作机制及对我国锂产业链的影响,并从构建自主可控供应体系、推动产业链技术迭代与协同升级、加强国家统筹与海外风险防控以及深化国际合作与全球治理参与四个维度提出应对策略,以增强供应链韧性、降低对外依赖并提升产业话语权,为我国新能源产业高质量发展与资源安全提供支撑。

作者:孙昱晗 宋双 吴喜庆 宋承斌

-

AI驱动下的汽车产业发展趋势及应对策略

-

价值重构 生态竞争

-

AI《汽车制造业》2026-1期

-

欧摩威中国:敏捷应需求,长期创价值

-

坚守与前瞻:桑普拉斯以技术优势赋能汽车行业

评论

加载更多