Adv-LiDAR: 只被激光雷达所见的「障碍物」

近些年的研究表明,神经网络等机器学习模型可以被精心设计的对抗样本攻击。这些精心设计的对抗样本可以欺骗模型输出任意指定的输出。在深度学习被越来越多的使用在现实生活中,尤其是对安全性要求极高的应用中的时候,这些可以欺骗模型的对抗样本就变得尤为危险。

最近有不少研究发现,通过贴贴纸等方法可以使基于图像的检测器无法识别路标甚至是障碍物。然而现今绝大多数的自动驾驶平台都会使用含有激光雷达(LiDAR)的多传感器融合作为障碍物是别的解决方案。那么在基于激光点云的检测器几乎统治性占领 KITTI 榜单的时候,只欺骗基于图像的检测器可能就不够了。

然而想要改变 LiDAR 的数据却不像改变摄像头所拍下的图像,只需打印贴纸那样简单。为此,来自密歇根大学,加州大学尔湾分校的研究人员提出 Adv-LiDAR——结合攻击传感器和对抗学习来攻击基于激光点云的检测器的新方法。

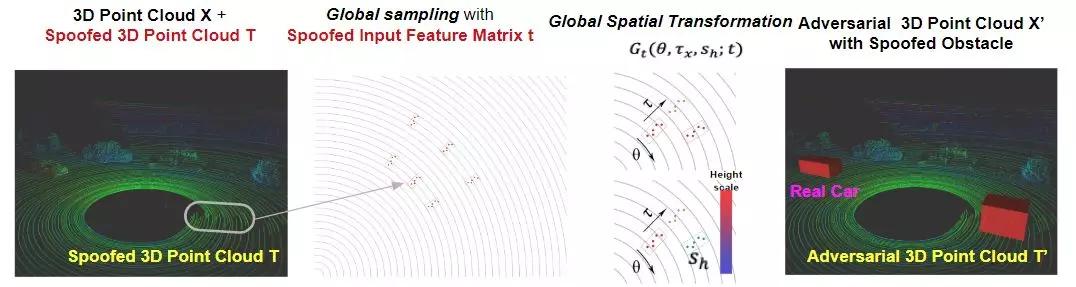

图 1. Adv-LiDAR 的过程图示

攻击模型

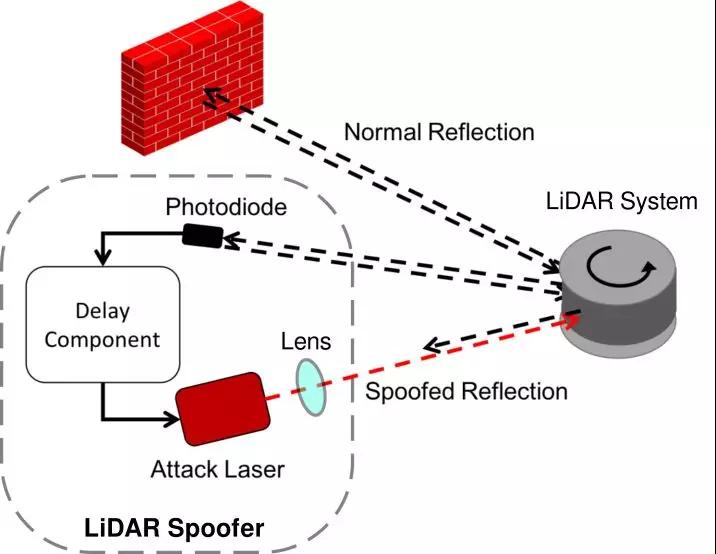

作者考虑通过对 LiDAR 传感器实施欺骗攻击来篡改激光点云数据。这种针对 LiDAR 的传感器攻击是由 Shin 等人提出并实现 [1]。通过这种可以添加激光点云的传感器攻击,作者把攻击目标设定为:在受害者自动驾驶车辆前方较近处伪造一个「障碍物」。这样的「障碍物」将更容易改变自动驾驶车辆的行驶决策与路径。

图 2. LiDAR 传感器攻击图示

Adv-LiDAR:安全分析新方法

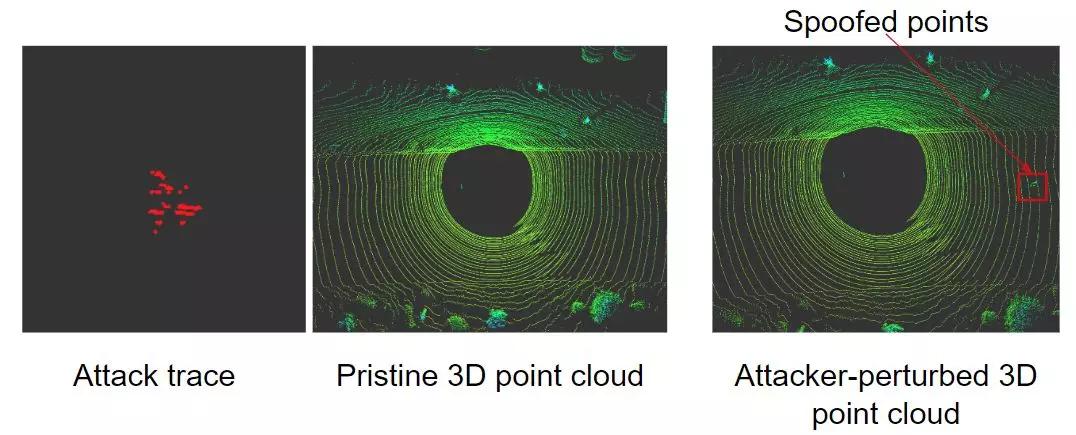

作者首先尝试了直接使用传感器攻击来伪造「障碍物」。通过复现传感器攻击,作者在实验室环境内采集了可以添加的激光点云数据,并用该采集的数据和自动驾驶汽车采集的路面数据进行合成来生成攻击所用的激光点云数据。作者尝试多种实验,通过随机放置伪造激光点云来进行攻击。然而作者发现这样并不能够成功使基于激光点云的目标检测器将其识别为障碍物。作者认为可能原因是传感器攻击产生的伪造点云数据只有一个比较狭窄的视角(大约 8 度),其不足以直接被识别为路上的障碍物。

图 3. 合成生成传感器攻击所用的激光点云图示

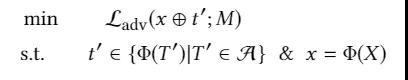

为了提升传感器攻击所能造成的影响,作者尝试利用神经网络模型的缺陷来尝试是否能成功使目标检测器误识别不存在的障碍物。为了解决该问题,作者首先需要将其表述为一个优化问题。这里 A 代表一系列可以通过传感器攻击来新增的激光点云数据,而 Phi 则代表了将激光点云预处理为模型输入特征的过程。

图 4. 将攻击目标转化为解优化问题

在表述优化问题的过程中,作者发现可以用空间变换和一个传感器攻击伪造的激光点云来描述传感器攻击新增的激光点云数据集合。于是作者将该优化问题表述成找到一个最优的对伪造的激光点云的空间变换方式。找到了最优的空间变换之后,就可以很容易的生成对应的激光点云样本。

实验

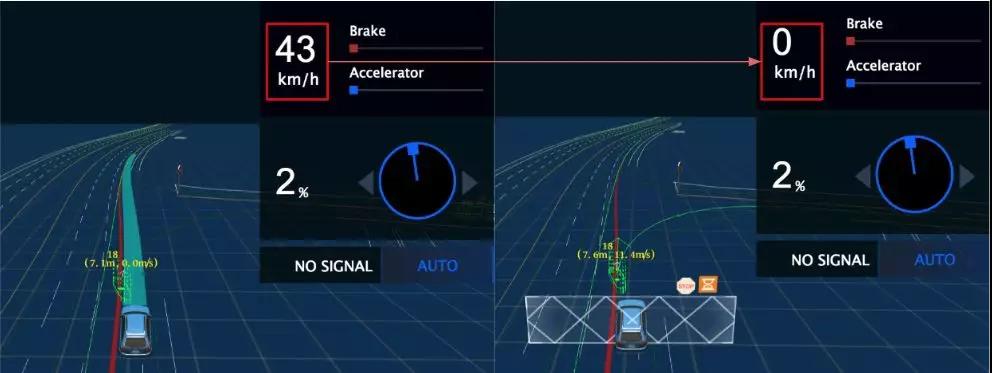

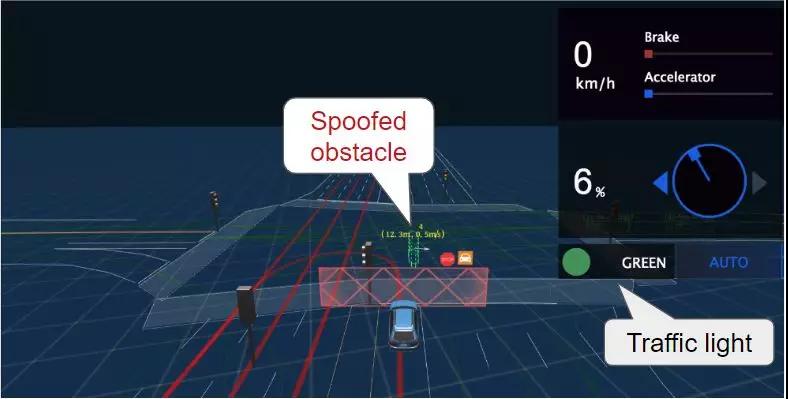

作者在百度 apollo 自动驾驶平台上进行攻击实验。结果显示攻击伪造「看不见」的障碍物可以达到接近 75% 的成功率。作者也通过模拟仿真的方式研究了该障碍物对自动驾驶系统决策和路径规划造成的影响并提出了两种不同的攻击场景。在移动过程中,模拟结果显示,该障碍物可以造成自动驾驶系统做出紧急刹车的决策。而对静止等待交通灯的车辆,模拟结果显示,由于该障碍物,无人汽车将因无法规划出正确的行进路线而停滞在原地。

图 5. 移动中的无人车因伪造的障碍物紧急刹车

图 6. 即使绿灯亮起也无法行进的无人车

总结

作者在这篇工作中提出 adv-LiDAR,一个用对抗学习来加强传感器攻击进而使其能欺骗基于激光点云的目标识别系统。该攻击由于不可见,更加难以被人类发现和预防。现阶段 adv-LiDAR 仍然受限于传感器攻击的较高成本,不够稳定以及其依赖于白盒攻击的限制。我们期待着这一方向有更多的研究,为将来更安全的自动驾驶技术做好准备。

机器之心

龚淑娟

李峥

热点文章

-

价值重构 生态竞争

2026-02-26

-

AI驱动下的汽车产业发展趋势及应对策略

2026-02-27

-

“锂欧佩克”的崛起与我国锂资源安全战略研究:挑战、影响与应对路径

2026-02-28

-

新能源车锂电池市场分析-2026年1月

2026-02-24

-

一文理清全主动智能底盘,主动悬架800V和48V之争的真相

2026-02-24

-

罗兰贝格注资Jonas Andrulis新创企业,深度赋能人工智能应用领域

2026-02-24

-

从炫技到生产力,均胜电子打通机器人落地工业场景应用“最后一公里”

2026-02-24

-

“锂欧佩克”的崛起与我国锂资源安全战略研究:挑战、影响与应对路径

锂是新能源汽车与储能系统的关键原材料,其战略价值日益凸显。2025年7月,玻利维亚、阿根廷和智利组建了全球首个锂资源协调机制——“锂欧佩克(LithiumOPEC)”,通过股权管控、上调开采费与推进定价主导等方式,试图重塑全球锂资源供应链的利益分配格局。本文分析其形成背景、运作机制及对我国锂产业链的影响,并从构建自主可控供应体系、推动产业链技术迭代与协同升级、加强国家统筹与海外风险防控以及深化国际合作与全球治理参与四个维度提出应对策略,以增强供应链韧性、降低对外依赖并提升产业话语权,为我国新能源产业高质量发展与资源安全提供支撑。

作者:孙昱晗 宋双 吴喜庆 宋承斌

-

AI驱动下的汽车产业发展趋势及应对策略

-

价值重构 生态竞争

-

AI《汽车制造业》2026-1期

-

欧摩威中国:敏捷应需求,长期创价值

-

坚守与前瞻:桑普拉斯以技术优势赋能汽车行业

评论

加载更多