未来HMI交互存在的形式

自主驾驶将是汽车发展中的下一场革命。实现自动驾驶的关键阶段是在L2至L4阶段,在这一阶段汽车处于共享模式。而自动驾驶模式下的HMI将是用于引导切换过程,使驾驶员接近驾驶任务,并提供丰富的娱乐和信息功能。

为无人驾驶汽车设计一个完全自主的系统还是有很多挑战,因为无人驾驶汽车能够像人一样操控汽车的性能,虚拟数字助理和人工智能是发展的主要驱动力。

车内HMI有能力提高乘客的感知,以确保车辆与乘员之间的顺利互动。全自动化汽车将通过触觉、视觉、动力和多形式结合等方式来提供多样化的交流。

从三维地图到人工智能,车内人机交互系统已经与过去的模型大不相同。

以下是一些影响行业的显著趋势,并将人机界面设计推向了新的高度。

未来HMI交互存在的形式

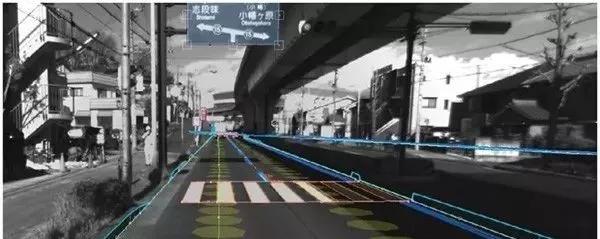

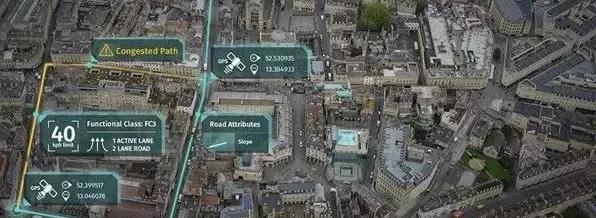

三维数字地图

对于下一代的自动驾驶汽车,地图不再仅仅是一个常用的功能,在自动驾驶模式下,它必须能够足够精确地指导车辆。自动驾驶所需三维数字地图必须比导航地图详细得多,这包括车道数、道路曲率等。自动车辆地图也需要实时更新,如果有道路施工或车道关闭,则需要在地图中反映出来。

在汽车行业实现5级自主性之前,许多汽车可能会提供有限的自动驾驶功能。比如,在高速公路上驾驶,导航就需要能够及时检测出何时进入和退出高速公路,以及何时允许自动驾驶选项。

AR

在未来,不仅导航变得更加方便,而且由于加入了增强现实(AR)可视化技术,导航也变得更加安全。哈曼和梅赛德斯-奔驰已经将AR导航引入了新的梅赛德斯-奔驰用户体验(MBUX)信息娱乐系统,以便更清晰、直观地沟通行动给司机。

摄像头提供周围环境的视频图像,然后会增加有用的导航信息。例如,箭头或房屋编号可以直接叠加到显示屏的触摸屏上。

目前,车内显示屏用于显示AR,但随着技术的发展,它将被投射到挡风玻璃上。随着汽车越来越自主,驾驶员监控导航系统的频率越来越低,AR可以用来显示各种类型的信息。该系统可以将沿途环境中的各种信息告知车辆乘客,而所有这些信息都可以映射到现实世界种。例如,当汽车经过剧院时,AR可以提供演出时间的信息。

语音助理

考虑到司机分心将带来的危险性,语音助理技术它与Alexa、GoogleHome和其他语音助手等(基于命令的车载解决方案)相比更易于使用。当前对所有语音助手的挑战是他们不能在完全车载模式下运行。因此,性能取决于车辆的连接性,这和我们5G的到来关联性很大哦。

研究表明,语音的分心程度和参与度可与人工操作相当,这项研究的CTS将语音接口的这些部分评定为与使用旋钮和按钮一样的要求。不仅如此,识别声音中的情绪:似乎是自然语言处理的下一步,其中情绪和情感是车内反应的触发因素。

触摸控制

触觉系统允许用户在半空中操作虚拟物体,就好像他们在触摸真实的物理控件一样。将触觉技术纳入控制系统补充了实际驾驶汽车的主要视觉任务。

用触觉进行控制会使用户体验更直观,能够让驾驶员始终将视线保留在道路上,减少了司机的分心还有精神负担,更加安全,显示在触摸屏上的按键就像真正的按钮一样。

显示屏的作用越来越大

随着技术和汽车产业的融合,旋钮、按钮和仪表正在越来越多地让位于新汽车的高清晰度屏幕和数字集群。目前车内屏幕的趋势是增加更多的屏幕,并以更大的尺寸显示。比如,特斯拉、拜腾等。

随着屏幕进入仪表板、后座、车窗等新位置,像素从数百万到数十亿不等。多年来,大多数原始设备制造商都认识到,继续保留一些硬按钮(除了显示)是一种有效的方法,可以让驾驶员随时使用那些经常被使用到的功能。专家预测,自动驾驶汽车将为每位乘客都创造出大屏的环境,同时并为一般信息传达提供额外的公用显示器。

HUD

平视显示器(HUD)是先进驾驶辅助系统(ADAS)的最新创新。它首先用在了军事战斗机中,它介于技术功能和安全功能之间。该设备通过直接在驾驶员视线中显示关键信息(如汽车的速度和导航方向)来减少危险的干扰。一些信息被投影到挡风玻璃上,另一些信息则将其投影到单独的屏幕上。

AI:汽车人机界面设计的关键推动者

使汽车变得“智能”的关键要素是人工智能平台,它将汽车的人机界面与车辆传感器、虚拟助理和云内容全面集成,并适应环境和用户的个人偏好和习惯。人工智能在车内的集成HMI将针对汽车环境进行优化,它知道诸如燃油或电池电量水平以及离最近的加油地点有多远;或者在几小时的午餐时间,沿途最受欢迎的当地餐馆是什么。

人工智能有助于将人机界面(HMI)转变为具有前瞻性的指挥中心。人工智能的初始功能将有价值的信息输入到HMI中,这包括驾驶员、车辆和周围环境信息。

随着驾驶形势的迅速变化和自动化程度的提高,驾驶员的角色将由操作员转变为更多的系统监督员。这些自动化机器ES正变得越来越复杂和“智能”,作为人类,我们需要思考作为“驾驶员”,我们在操作车辆时需要和想要看到的复杂性有多大,这可能会对我们的行为产生重大影响。

NextDesign

龚淑娟

李峥

热点文章

-

价值重构 生态竞争

2026-02-26

-

AI驱动下的汽车产业发展趋势及应对策略

2026-02-27

-

“锂欧佩克”的崛起与我国锂资源安全战略研究:挑战、影响与应对路径

2026-02-28

-

新能源车锂电池市场分析-2026年1月

2026-02-24

-

一文理清全主动智能底盘,主动悬架800V和48V之争的真相

2026-02-24

-

罗兰贝格注资Jonas Andrulis新创企业,深度赋能人工智能应用领域

2026-02-24

-

从炫技到生产力,均胜电子打通机器人落地工业场景应用“最后一公里”

2026-02-24

-

“锂欧佩克”的崛起与我国锂资源安全战略研究:挑战、影响与应对路径

锂是新能源汽车与储能系统的关键原材料,其战略价值日益凸显。2025年7月,玻利维亚、阿根廷和智利组建了全球首个锂资源协调机制——“锂欧佩克(LithiumOPEC)”,通过股权管控、上调开采费与推进定价主导等方式,试图重塑全球锂资源供应链的利益分配格局。本文分析其形成背景、运作机制及对我国锂产业链的影响,并从构建自主可控供应体系、推动产业链技术迭代与协同升级、加强国家统筹与海外风险防控以及深化国际合作与全球治理参与四个维度提出应对策略,以增强供应链韧性、降低对外依赖并提升产业话语权,为我国新能源产业高质量发展与资源安全提供支撑。

作者:孙昱晗 宋双 吴喜庆 宋承斌

-

AI驱动下的汽车产业发展趋势及应对策略

-

价值重构 生态竞争

-

AI《汽车制造业》2026-1期

-

欧摩威中国:敏捷应需求,长期创价值

-

坚守与前瞻:桑普拉斯以技术优势赋能汽车行业

评论

加载更多