手势识别:车内交互方式的新宠?

从汽车被发明以来,人车交互的方式在不断变化。而在最近几年,这种趋势开始变得越来越明显。仅仅在车载信息娱乐系统中,交互方式也开始从最早的实体按键,转向包含按键、触屏以及语音等等方式在内的多维交互方式。

虽然交互方式在变,但遵从的逻辑从来都没变:方便与安全。比如扩大了手触面积的卡片式 UI、智能后视镜、抬头显示、智能 AI 语音、AR 导航等等,都是为了让驾驶员在开车的时候尽可能方便地传递指令,减少注意力的分散,保证安全。

目前来看,车载语音交互已经比较普及,很多新车型上都有搭载。但它还是有自己的局限性,比如识别率、识别速度、对自然话术的支持等等都还不完善。这样一来,有时候反而会给驾驶造成额外的负担。

这时如果能像科幻片里那样,动动手指就能下达某些指令,可能会是一种更好的解决方案。

事实上,主机厂们也确实再往这个方向发展。2015 年,宝马率先发布了搭载手势识别的 7 系,而且前前后后也不断有 OEM 在尝试推出搭载这项功能的量产车(比如奔驰、拜腾、君马)和 demo(奥迪、福特、大众等),所以这更加深了我们对手势识别的好奇心。

手势控制正在成为一种更值得期待的车内交互方式。

手势识别在车内都能做什么?

通过不同的手势,手势交互可以实现接挂电话、调节音量、选择歌曲、控制导航、控制车辆(空调、座椅、窗户等)等功能,还包括主驾和副驾、后排乘客交互的多种场景。

虽然手势控制能实现的功能不少,甚至和语音交互的功能还有一定重复。但是在我看来,手势和语音的关系绝不是非此即彼,一定是互相成就。想象一下,当你目视前方,用手指着天窗说打开,然后天窗就打开了,是不是还挺有意思的?

未来人机交互一定是多维度的。例如宝马全新 5 系就配备了「五维人机交互界面」,其中包括自然语音识别、手势控制、触控屏幕、iDrive 系统和热敏按键。

这种多模态交互才是未来。

另外,如果我们把视线从驾驶员的手势扩散开来,类似的技术在驾驶场景还能实现更多功能。

除了驾驶员的手势之外,手势识别的技术还能识别车外人员的动作。以后,这个功能也许还能识别交警指挥车辆的动作,或者周围骑自行车的人做出的手势。这样既能增加驾驶的安全性,又能促进自动驾驶的发展。

这些技术还可以实现驾驶员监测,是和目前手机的面部识别解锁类似的技术原理。从全球来说,法律规定在 L2 向 L3 级别的自动驾驶方案过渡时,驾驶员必须时刻监控车辆驾驶,所以随时监控驾驶员的状态在未来一定是必需的部件,而且这个未来很快就要到了。

既然手势交互和背后的技术对于驾驶有这么多帮助,所以我们有必要了解一下背后的原理。

实现手势识别的 3 种方案

前方高能,所以请准备好开始烧脑。

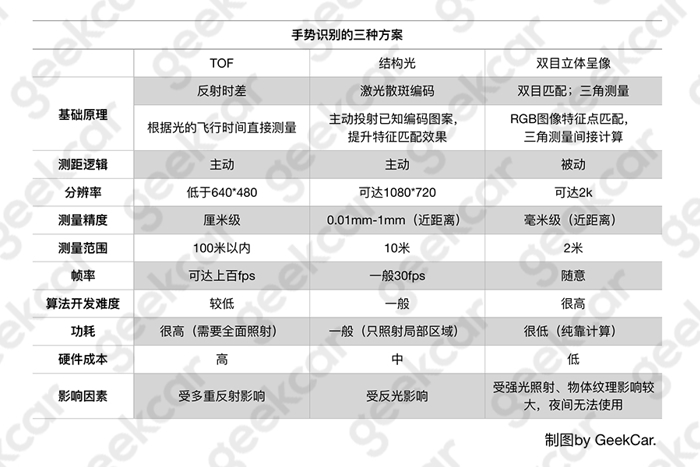

根据硬件实现方式的不同,目前行业内所采用的手势识别大致有三种:光飞时间(Time of Flight)、结构光(Structure Light)以及双目立体成像(Multi-camera)。

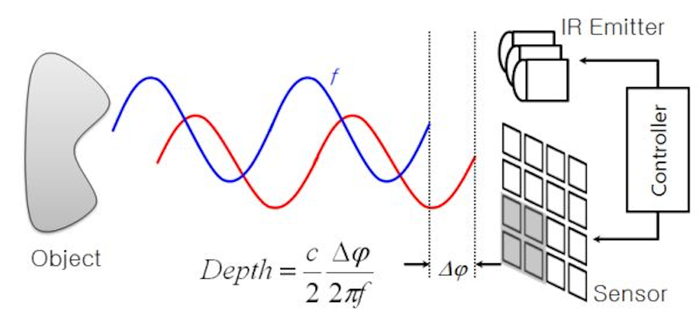

光飞时间(Time of Flight):通过光的飞行时间来计算距离。

光飞时间的原理很简单,先用红外发射器发射调制过的光脉冲,再用接收器采集反射回来的光脉冲,最后根据往返时间计算物体间的距离,从而判断手势。

其实主要就是依据距离=光速*时间。光速是一定的,就可以通过时间差推算距离差。

结构光(Structure Light):主动投射已知编码图案,再计算物体位置。

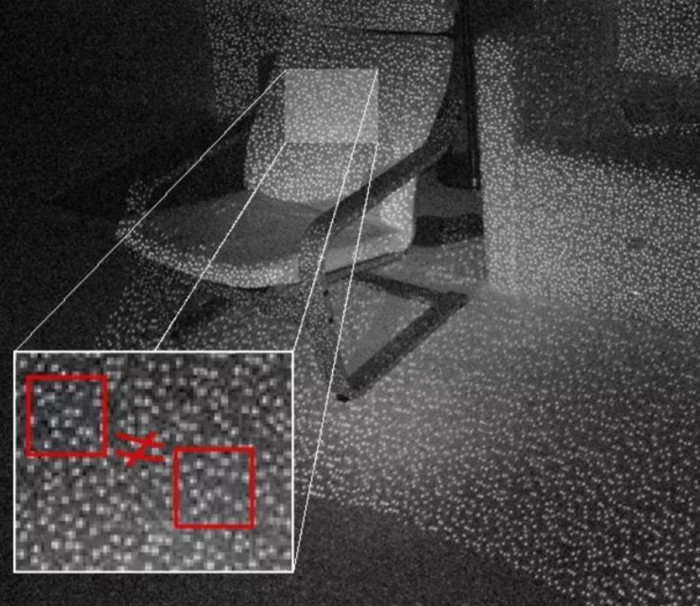

结构光要先通过红外激光器,将具有一定结构特征的光点投射到目标物体上,再由红外摄像头收集反射的结构光图案。

因为这些光斑投影在被观察物体上的大小和形状根据物体和相机的距离和方向而不同,所以根据三角测量原理可以计算出物体各个点的具体位置,根据前后位置差异从而能够判断手势。

双目立体成像(Multi-camera):两个摄像头采集位置信息,再将畸变数据计算成可用数据。

双目立体成像非常依赖算法,而且算法的难度和分辨率和检测精度挂钩。分辨率和检测精度越高,计算就越复杂,还会导致实时性较差。它主要分两个步骤:1. 采集信息。2. 计算畸变数据。

1. 采集图像信息。通过两个摄像机提取出三维位置信息,并进行内外部参数的匹配。(摄像机本身存在畸变,如果不经过标定,原本的矩形会显示成不规则的圆角四边形)

2. 计算畸变数据。通过对比经过校准的立体图像,获得视差图像,再利用摄像机的内外参数进行三角计算获取深度图像,根据前后位置的区别进行手势识别。

像分辨率、成本、测量精度这种问题,三种方案虽然有高有低,但基本都还说得过去,功耗在车内也不是大问题。

要判断哪种方案合适,要从以下几点着手:1. 是否能适应各种环境?2. 是否具有优异的实时性?3. 在样本范围内,数据误差是否可控?4. 成本是否可控?5. 体积是否可控?6. 硬件插件是否成熟?

前三点是非常重要的,因为汽车会处在各种环境内,所以抗干扰性、数据实时性、数据准确性非常重要。

结构光的分辨率高,计算量少,功耗也比较低,此前有很多成型的解决方案,还有 Inter 支持的 RealSense SDK,开发周期较短。但是它受限于主动投射的原理,非常容易受到强光和光滑平面(如镜子)的影响,室外基本不能使用,这点算是致命的。

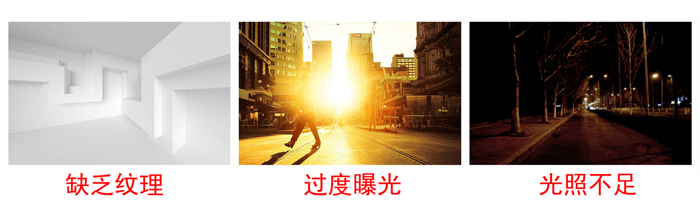

双目立体成像的硬件成本比较低,但是它过于依赖图像特征匹配(后期计算),需要很高的计算资源。想要更高的分辨率,计算就越复杂,这就导致它实时性比较差。而且它在光照较暗、过度曝光或者场景本身缺少纹理的情况下,很难进行特征提取匹配。和结构光一样,在抗干扰性这点上它做的不好。

TOF 方案的分辨率很低,测量精度也不如其他两种方案,但是对于车内手势识别来说已经够了。因为需要光线的全面照射,所以功耗很高,但是这在汽车环境中也不算大事。而且它的体积可控;测量误差在整个范本内比较固定;虽然计算量大,但是算法难度较低;最重要的是它受外界环境干扰较小。综合来看,TOF 方案是个比较实用的选择,也是很多供应商都在努力的方向。

目前都有哪些具体车型应用?

目前带有手势识别的量产车型有宝马、君马;正在计划量产的车型有拜腾、奔驰。

宝马家族的 7 系、5 系以及 X7、X5、X3 现在带有手势识别功能,其中 7 系是全球第一个装载手势识别的量产车型。它的手势识别区域为车机屏前方,供应商为德尔福,采用的是 TOF 方案,可以识别 7 种预设手势,包括接挂电话、选择歌曲、调节音量、控制导航等功能。

而国内第一个配备手势控制的量产车型是众泰旗下的君马 SEEK5。它在 2018 年 8 月上市,可以识别 9 种动作,包括接挂电话、选择歌曲、调节音量以及一个小彩蛋:握拳手心向上打开变为手掌,界面会出现玫瑰花。

拜腾在 2019 年底即将量产的车型采用了 48 寸的大屏。由于屏幕巨大,手势控制也作为其中必不可少的交互方式之一。它的供应商是国内的凌感科技,采用的是双目立体成像方案,可以识别 5 种手势,具体功能还没有公布。

奔驰最新的 MBUX 采用了一种「非接触式」的控制方式,当手接近屏幕的时候,系统就可以感应到手部操纵了,所以不需要实际接触就可以使用屏幕。而且在全新 CLA 上,把手伸向后视镜就可以打开/关闭阅读灯,这个功能在阳光或者黑暗环境下都能使用。

根据最新消息,LG 将会为奔驰的一款车型提供手势识别系统,它可以实现巡航控制、调整音量等功能。LG 现在还在研发一种驾驶辅助系统,计划在今年末或明年初向戴姆勒交付。

另外,还有一些 OEM 提出过自己的概念,但是目前还没有量产。

比如 2014 年,福特在 Mobbi 车载系统上展示过自己的 demo,可以实现控制空调、导航、音量、座椅位置等功能(供应商是英特尔,采用的是结构光方案);2015 年,奥迪在 CES 上用 Q7 展示了针对后排乘客的手势控制的 demo;2016 年,大众在 CES 上用 Golf-E Touch 概念车上展示过手势识别的 demo,采用的是 TOF 方案;2018 年,奇瑞在北京车展上展示了 LION 智能座舱,可以实现控制娱乐系统和地图。

说了这么多车型和 demo,那手势识别在车内用起来到底怎么样?答案可能依然不尽如人意,原因其实不难分析。

首先,手势交互功能还在初期阶段,对于高识别率和防误触的界限很难界定。其次用户还没习惯手势交互的方式,更多时候会下意识的使用原有的交互方式。

当然,教育市场是每项新技术落地都必须要面对的,随着体验的升级以及更多车型的普及,这些问题也会逐渐消失。比如之前我也很不习惯用 Siri,但是现在我找不到 App 时就习惯让 Siri 帮我打开应用。我找不到手机的时候,也会满屋子的喊 Siri,直到它回应我「什么事?」。

供应商在做什么?

目前,能够提供手势识别的不仅有大的 IT 公司以及 Tier 1(比如谷歌、德尔福、大陆、伟世通、微软、三星、Leap Motion 等),还有一些初创公司(比如未动科技、凌感科技、微动、极鱼科技、京龙睿信、光晕网络)。

这次我们重点挑几家国内公司,来看看他们是如何进行产品布局的。

未动科技(Untouch):

未动科技是一家智能视觉交互技术提供商,产品包括:3D 手势识别系统,智能驾舱解决方案、驾驶员监控系统。

2017 年 7 月,它发布了 4 款 3D 视觉交互产品:3D 手势识别产品:黎曼平台;3D 人脸识别产品:欧拉平台;SLAM 产品:笛卡尔平台;场景重建产品:高斯平台。

其 3D 手势识别产品「黎曼平台」可以基于深度图实现手部 23 个关节点识别与 26 自由度追踪,延迟在毫秒级。而且它还被全球著名的 TOF 深度传感器厂商 PMD 选择,作为中间件推出了一套完整的手势识别软硬件一体方案。

同时,其他产品还被应用在手机、机器人、无人机、AR/VR 等智能设备上。

它的核心竞争优势有两个:一个是构建了智能视觉交互技术的基础性平台,另一个是数以 PB 计的深度数据积累。

凌感科技(uSens):

凌感科技专注于三维人机交互解决方案,是拜腾手势识别功能的供应商,采用的是双目立体成像方案。主要产品有:手势追踪、位置追踪、混合现实。

2014 年,uSens 就研发出全球第一个在有线及移动端实现基于 inside-out 技术路线的 26 自由度手势追踪以及 6 自由度头部位置追踪技术,可以通过识别手部 22 个关节点识别和 26 个自由度追踪。

2016 年,uSens 发布了 Fingo 手势交互模组,2017 年发布了新版 Fingo SDK。它可以识别 10 余种动态和静态手势,识别精度在 0.5cm-1cm,官方表示识别准确度可达 99%以上,可跨平台操作。还可以根据场景定义扩展新手势,并自定义相应功能。

2016 年,他们还与戴姆勒中国 IT 创新实验室一起展示了车载手势交互的新成果。通过他们的手势识别技术,体验者可以在 VR 场景中观察 3D 汽车模型的细节,还可以进行交互。

微动(Vidoo):

微动以机器视觉和深度学习为核心技术,可以通过多种摄像头技术(IR 红外单目模组、IR 红外双目模组、RGB 单目模组)提供多种解决方案(提供 AR/VR 技术、车载手势控制方案、智能家居解决方案、虚拟触控解决方案)。

微动的手势控制采用的是双目立体成像方案,可以识别 8 种手势动作。

IR 红外单目模组可以应用在跑步机、抽油烟机、OTT 机顶盒上;IR 红外双目模组可以用在车载电子、VR\AR、广告终端;RGB 单目模组可以运用在无人机、智能新零售、智能手表上。

极鱼科技:

极鱼科技是一家基于 TOF 手势交互技术实现人机交互的解决方案提供商,主要面向汽车市场。

它以手势为核心,同时还会结合眼球识别交互、面部识别、声音识别、光学技术、交互体验设计、人工智能等技术。它支持车厂自选 3-5 个手势并自定义功能,目前他们正在探索与天窗、座椅、车门之间的裸手交互。

2017 年它入选 Starup Autobahn 第一期加速营,从而获得了与戴姆勒合作的机会。

行业总结以及对手势识别功能的愿景

从这些具体的产品或者 demo 上,我们能看到不论是 OEM 还是供应商,他们要的都不只是手势识别这一种功能,而是一个整体的智能驾驶座舱,里面涵盖了更多融合性的功能。

首先,手势识别必然会和语音识别等其他交互方式进行集成。供应商哪怕自己不做,也要和其他公司合作。比如思必驰、云知声等语音公司都投资了相关手势识别厂商。

另外,手势识别、语音识别和 HUD 结合也是一个不错的选择,所以也就出现了专门依托 HUD 来研发技术的供应商,比如京龙睿信和光晕科技。

依据手势识别的基础原理,还可以研发驾驶员监测等产品,这是 L2 向 L3 过度时期必不可少的一项功能。

所以很多供应商不仅仅只是提供手势识别的方案,它们还能提供其他相关产品,甚至涉猎到了智能家居、AR\VR 等领域。这其实是一件好事,这将有助于他们提供一套功能更加融合的的智能交互系统。

最后让我们回到手势识别本身。当我们在描述一家供应商的手势识别功能时,总是谈它能识别几种手势,好像能识别的越多就越厉害。但原则上供应商能实现 N 种手势,还能让 OEM 自定义功能。

所以车内手势控制不求多,更不求难,大家要的都是方便,又不是像阿汤哥拍《少数派报告》。

真正的核心问题应该是,用户们到底能记住几种手势控制功能?又真正需要哪些功能?哪些手势的学习成本更低?哪些手势更容易上手?设置的手势动作符合人类的原始反应,才是 HMI 的第一原则。

说到底,我们现在车内的手势识别还处于发展初期,能实现的功能和准确率也很有限,但这并不能阻止我们对这一功能的憧憬。

总有一天,配合人脸识别、静脉识别、眼球识别,我们每个人都有一个超级 ID,进入车内中控台上的拟人化助手会通过全息影像的形式对你微笑,跟你说早安,我们在车内可以将手势识别、语音识别运用地流畅自如,通过前挡风的 AR 导航可以对周围状况一览无余,车内的大屏可以与工作的电脑连接,车内的智能化设备与智能家居也是共通的……

总之,这一定不是空想,而是未来。

获取更多评论